Jakub Pachocki, director científico de OpenAI, anticipa una nueva era de modelos de razonamiento capaces de investigar, programar y diseñar sin supervisión humana. La compañía prepara además un modelo de pesos abiertos para investigadores.

OpenAI, la empresa con sede en San Francisco responsable de la revolución generada por ChatGPT desde su lanzamiento en 2022, avanza hacia una nueva frontera tecnológica. Más allá de los conocidos asistentes virtuales, la firma desarrolla lo que denomina modelos de razonamiento, una categoría de inteligencia artificial (IA) pensada para tareas complejas como la programación autónoma, el diseño de hardware y la generación de hipótesis científicas.

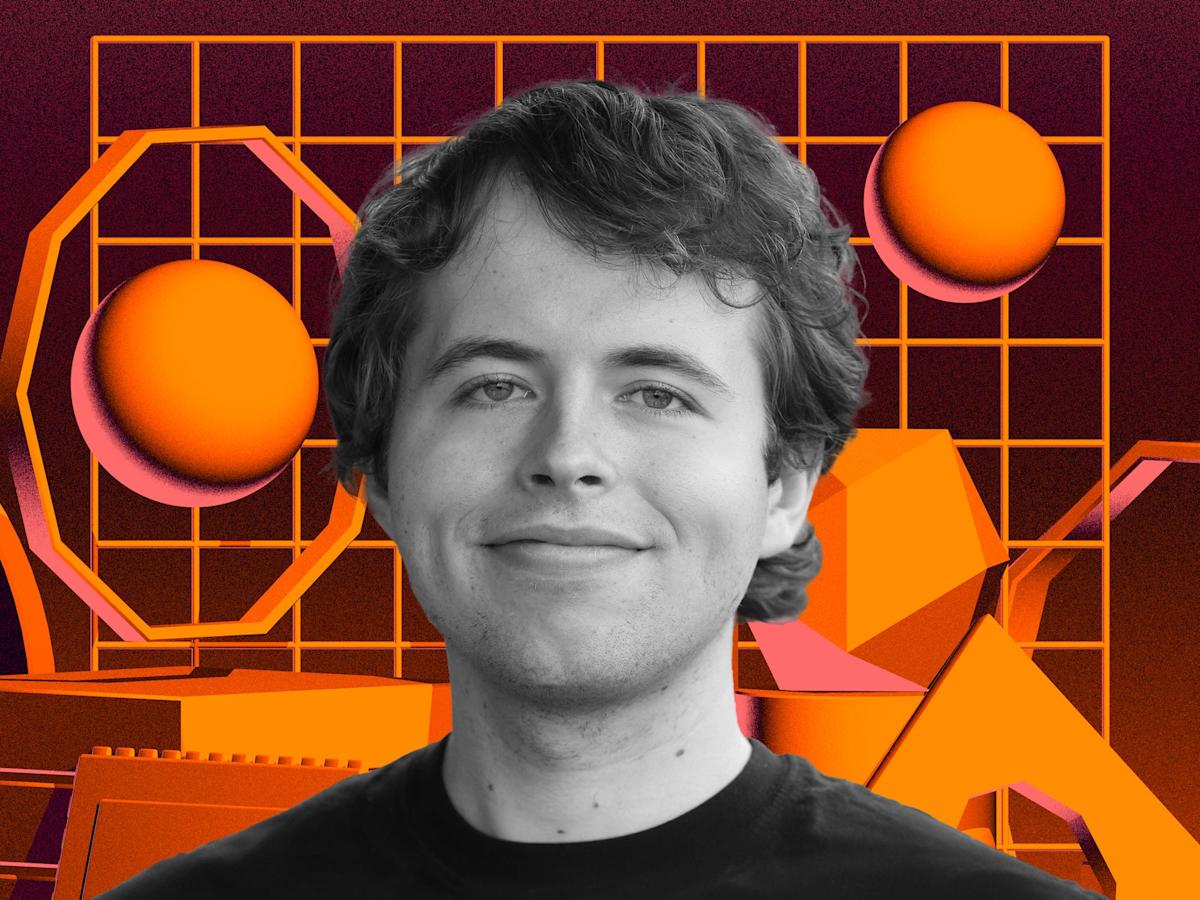

Jakub Pachocki, director científico de OpenAI desde 2024, lidera el equipo que trabaja en estos desarrollos avanzados. “Espero que pronto tengamos inteligencias artificiales realmente capaces de producir ciencia original”, afirmó en una entrevista con Nature. “Veremos mucho progreso, por ejemplo, en ingeniería de software autónoma, diseño automático de componentes de hardware y aplicaciones similares en otras disciplinas”.

Modelos que piensan por sí mismos

A diferencia de las versiones iniciales de ChatGPT, que requerían una guía constante del usuario, los nuevos modelos como Deep Research ya pueden operar de forma autónoma durante 10 o 20 minutos y generar contenido útil. “La cantidad de cómputo que usamos hoy para esas tareas es mínima”, explicó Pachocki. “Si uno tiene un problema científico abierto, vale la pena dedicar mucho más poder de cómputo a resolverlo”.

Este tipo de avances proviene, en parte, del uso intensivo del aprendizaje por refuerzo con retroalimentación humana. “El proceso original de ChatGPT incluía una etapa de preentrenamiento no supervisado, donde el modelo absorbía enormes cantidades de datos para construir una especie de ‘modelo del mundo’. A partir de ahí, lo convertimos en un asistente útil mediante refuerzo”, detalló.

Sin embargo, la diferencia con los nuevos modelos es que esta fase de entrenamiento reforzado no solo extrae habilidades útiles, sino que permite al modelo desarrollar su propia manera de razonar. “Lo importante es entender que los modelos no aprenden a pensar en el vacío. Están enraizados en un preentrenamiento masivo. Mucho de mi trabajo se centra en cómo integrar ambas etapas y comprender su interacción”, señaló el científico.

Una apertura esperada por la comunidad científica

Durante años, OpenAI fue criticada por mantener sus modelos bajo licencia cerrada, lo que impedía a investigadores construir sobre ellos. Frente a esta crítica, Pachocki anticipó una apertura importante: la compañía lanzará un modelo de pesos abiertos, es decir, un sistema que los científicos podrán estudiar, modificar y escalar.

Esta decisión busca no solo facilitar la innovación colaborativa, sino también responder a la creciente demanda de transparencia en el entrenamiento de IA. La medida cobra especial relevancia en un momento en que OpenAI y otras tecnológicas enfrentan cuestionamientos por el uso intensivo de datos protegidos por derechos de autor y el alto consumo energético de sus sistemas.

¿IA con capacidad de razonamiento real?

Una de las preguntas más frecuentes sobre los modelos actuales es si realmente razonan o si simplemente imitan el razonamiento humano. Pachocki fue claro: “Tenemos que ser honestos. La forma en que los modelos funcionan es diferente a cómo lo hace el cerebro humano. Un modelo preentrenado ha aprendido ciertas cosas sobre el mundo, pero no tiene conciencia de cómo las aprendió ni del orden temporal en que lo hizo”.

Esta diferencia conceptual no impide que los modelos resulten útiles en entornos complejos. De hecho, OpenAI apuesta a que estas capacidades evolucionen hasta convertirse en herramientas autónomas de investigación científica.

El impacto en los negocios y la industria tecnológica

El desarrollo de modelos capaces de realizar investigación original o diseño tecnológico sin intervención humana podría redefinir industrias enteras. Empresas de biotecnología, finanzas, ingeniería y software están observando con atención los movimientos de OpenAI, dado que estas herramientas podrían significar una reducción radical en los tiempos de desarrollo, validación y escalado de soluciones complejas.

A mediano plazo, estas innovaciones también podrían generar nuevos dilemas legales, éticos y laborales. ¿Quién será el autor de un descubrimiento generado por IA? ¿Qué sucede si un modelo diseña una tecnología patentable?

Aunque no hay respuestas simples a estas preguntas, Pachocki cree que la clave está en mantener un desarrollo responsable y en diálogo con la comunidad. Mientras tanto, OpenAI se posiciona una vez más en la vanguardia, no solo de la tecnología, sino también del debate global sobre los límites de la inteligencia artificial.