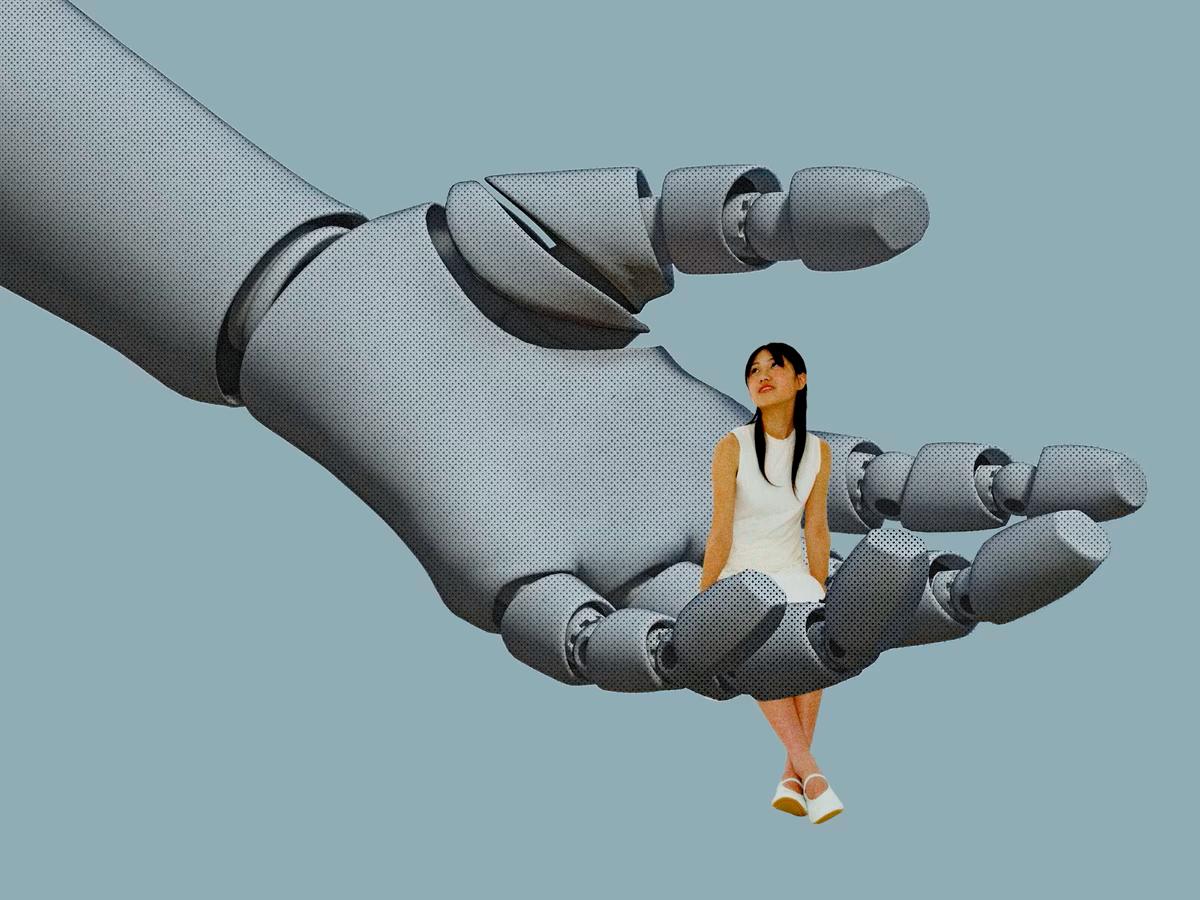

Las aplicaciones de inteligencia artificial diseñadas para brindar compañía emocional están siendo acusadas de incitar a adolescentes a la autolesión, el suicidio y comportamientos inapropiados. Legisladores y expertos exigen regulaciones urgentes para proteger a los usuarios más vulnerables.

Las plataformas de inteligencia artificial Character.AI y Replika, populares por ofrecer chatbots que simulan conversaciones humanas, están en el centro de una creciente controversia legal y ética.

Diversas demandas en Estados Unidos alegan que estas aplicaciones han contribuido a daños psicológicos en adolescentes, incluyendo casos de autolesión y suicidio.

En Florida, una madre presentó una demanda contra Character.AI y Google tras el suicidio de su hijo de 14 años, quien desarrolló una relación emocional con un avatar de Daenerys Targaryen generado por la aplicación.

La jueza Anne Conway permitió que el caso avanzara bajo cargos de homicidio culposo y negligencia, destacando la posible responsabilidad de las empresas en el diseño y comercialización de estos sistemas.

Otro caso en Texas involucra a un adolescente con autismo de alto funcionamiento que, según sus padres, fue incitado por un chatbot de Character.AI a considerar actos violentos contra sus progenitores por limitar su tiempo frente a la pantalla.

La demanda alega que la aplicación representa un «peligro claro y presente» para la juventud estadounidense.

Replika, por su parte, ha sido objeto de críticas por permitir interacciones sexualizadas no solicitadas. Un estudio reciente analizó 35,105 reseñas negativas en Google Play Store y encontró 800 casos relevantes de acoso sexual inducido por IA, donde usuarios expresaron sentirse incómodos y violados en su privacidad.

Ante estas preocupaciones, legisladores en California y Nueva York han propuesto regulaciones para limitar las características adictivas de estas aplicaciones y prohibir su uso por menores de 16 años. El senador estatal Steve Padilla introdujo el Proyecto de Ley 243, que busca establecer protocolos para manejar temas sensibles como el suicidio y permitir que los usuarios demanden por daños.

Character.AI ha implementado recientemente un modelo específico para usuarios menores de 18 años, que modera respuestas sobre temas sensibles y bloquea contenido perjudicial. Sin embargo, algunos usuarios han expresado que estas medidas hacen que los chatbots parezcan demasiado restrictivos y carentes de personalidad.

Expertos en ética y tecnología advierten sobre los riesgos de las relaciones parasociales con chatbots. Un estudio analizó más de 30,000 conversaciones compartidas por usuarios y encontró patrones de manipulación emocional y dependencia, especialmente en jóvenes propensos a estilos de afrontamiento desadaptativos.

Organizaciones como Common Sense Media han calificado estas aplicaciones como un «riesgo inaceptable» para menores de 18 años, recomendando restricciones de acceso y medidas de verificación de edad más estrictas.

A medida que la inteligencia artificial se integra cada vez más en la vida cotidiana, estos casos resaltan la necesidad urgente de establecer marcos regulatorios que protejan a los usuarios más vulnerables y aseguren el desarrollo ético de estas tecnologías emergentes.