El CEO de OpenAI reconoció que aún no existe un marco legal que proteja la privacidad de los usuarios cuando utilizan inteligencia artificial para consultas emocionales o personales. “Deberíamos tener el mismo nivel de privacidad que con un terapeuta”, afirmó.

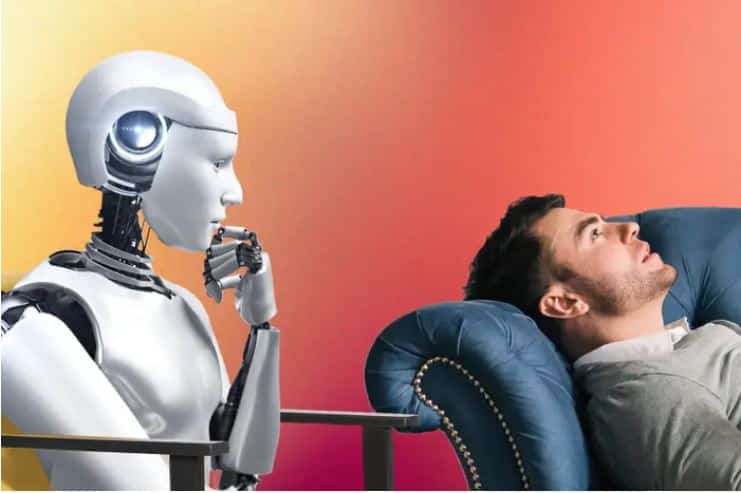

El uso de inteligencia artificial como apoyo emocional o guía personal viene en alza, especialmente entre los más jóvenes. Pero una advertencia reciente del CEO de OpenAI, Sam Altman, reabre el debate sobre los límites de la privacidad en la era de los chatbots inteligentes: “Las personas hablan sobre las cosas más personales de sus vidas con ChatGPT […] y no hay confidencialidad legal para eso todavía”, aseguró.

Durante una entrevista en el pódcast This Past Weekend del comediante Theo Von, Altman reflexionó sobre el vacío legal que rodea a las interacciones entre humanos e inteligencias artificiales. A diferencia de lo que ocurre con un médico, un terapeuta o un abogado, no existe hoy ninguna figura de “privilegio legal” que ampare a los usuarios que comparten información sensible con un modelo de IA.

“Los jóvenes usan ChatGPT como si fuera un terapeuta, un coach de vida. Plantean problemas de pareja, dilemas personales, preguntas íntimas. Y si uno le contara eso a un terapeuta real, la ley protege esa conversación. Pero nosotros no hemos resuelto eso todavía con la IA”, subrayó Altman.

La preocupación va más allá de lo ético: en un contexto judicial, OpenAI podría verse obligada a entregar registros de conversaciones, algo que el propio CEO calificó como “muy jodido”. En sus palabras: “Deberíamos tener el mismo concepto de privacidad para tus charlas con una IA que para tus charlas con un terapeuta. Y nadie pensaba en esto hace apenas un año”.

Esta carencia de garantías legales ya genera tensiones judiciales. OpenAI enfrenta una orden judicial en su litigio con The New York Times, que exigiría conservar los chats de cientos de millones de usuarios de ChatGPT, excepto los clientes corporativos de ChatGPT Enterprise. En su página oficial, la compañía calificó esta medida como “un exceso” y anunció que está apelando.

La situación genera un precedente delicado. Si la justicia puede acceder libremente a las conversaciones de los usuarios con IA, podrían multiplicarse las solicitudes legales de datos, incluso en investigaciones penales. Esto ya ha ocurrido con otras compañías tecnológicas, obligadas a entregar datos de usuarios en procesos judiciales.

El debate también se enmarca en una creciente sensibilidad sobre la privacidad digital. Tras la anulación del fallo Roe vs. Wade en EE.UU., muchas usuarias dejaron de usar apps de seguimiento menstrual por temor a que sus datos fueran utilizados en su contra, y migraron a plataformas más seguras como Apple Health, que ofrece encriptación.

Altman, consciente de estas preocupaciones, le preguntó al propio Theo Von si usaba ChatGPT con frecuencia. El comediante respondió que no, justamente por cuestiones de privacidad. Altman coincidió: “Tiene sentido esperar a tener una claridad legal sobre la privacidad antes de usar mucho esta tecnología”.

Mientras tanto, OpenAI reconoce que la falta de un marco de confidencialidad podría ser un obstáculo para la adopción masiva de su herramienta, especialmente en usos más sensibles como salud mental o relaciones personales.

La advertencia de Altman plantea un desafío clave para el sector: ¿cómo se regula una tecnología que no tiene precedentes legales? Mientras la IA avanza más rápido que la legislación, millones de personas ya están compartiendo sus secretos más íntimos con algoritmos que, por ahora, no están obligados a guardar silencio.