Mientras la industria debatía sobre orquestas de agentes de IA, una idea más simple y potente, nacida en un tuit, emergió para centrar la conversación en el marco contextual brindado a los modelos.

En el vertiginoso mundo de la inteligencia artificial, las tendencias nacen y mueren a la velocidad de un ciclo de GPU. Durante un tiempo, el «Santo Grial» parecía ser la creación de sistemas «multi-agente», pero un nuevo consenso, más pragmático y potente, está ganando terreno. Su nombre: Ingeniería de Contexto.

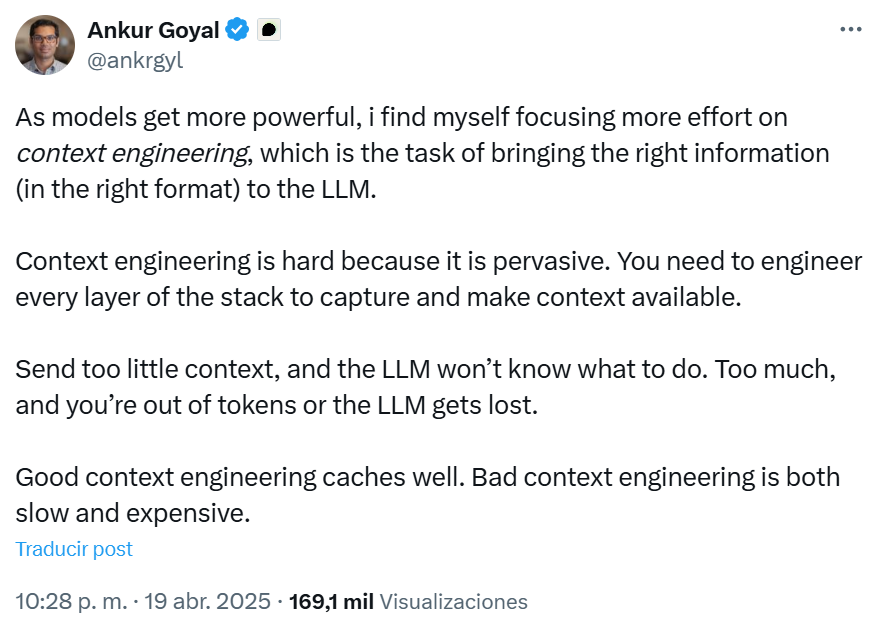

La historia de este cambio de paradigma no comenzó en un blog post de una gran compañía, sino en un tuit, lo que demuestra la vertiginosidad del cambio que estamos atravesando. En abril de 2025, Ankur Goyal, fundador y CEO de Braintrust una plataforma integral diseñada para construir y evaluar aplicaciones de inteligencia artificial, lanzó la idea al mundo. Él fue el primero en acuñar el término «Ingeniería de Contexto», proponiéndolo como una disciplina diferenciada.

Su argumento era simple y profundo. “A medida que los modelos se vuelven más potentes, me encuentro centrando más esfuerzos en la “ingeniería de contexto”, que es la tarea de aportar la información adecuada (en el formato adecuado) al LLM.”

La idea comenzó a circular en círculos especializados, pero encontró su primer gran caso de uso dos meses después.

En junio, Walden Yan, fundador de Cognition AI, publicó su artículo «No construya multiagentes«. Yan tomó el concepto de Ingeniería de Contexto y lo aplicó directamente al problema de la fragilidad de los sistemas multi-agente. Su posteo fue el primero en conectar los puntos a gran escala: cuando un equipo apila agentes, el fallo casi nunca es del modelo, sino del contexto que cada uno recibe. Yan no inventó el término, pero le dio su primera aplicación «asesina».

El eco viral que lo consolida todo

Con el concepto ya definido por Goyal y su aplicación práctica demostrada por Yan, solo faltaba el catalizador para que explotara. Este llegó en forma de validación por parte de las figuras más influyentes del sector.

Primero fue Tobi Lütke, el CEO de Shopify, quien tuiteó:

“Me gusta más el término «ingeniería del contexto» que el de ingeniería de prompt. Describe mejor la habilidad principal: el arte de proporcionar todo el contexto para que la tarea sea plausiblemente resoluble por el LLM.”

Días después, Andrej Karpathy uno de los miembros fundadores de OpenAI y actual fundador de Eureka Labs, empresa de IA+Educación vio el hilo y lo reposteó con un simple pero demoledor mensaje:

“+1 para «ingeniería del contexto » sobre “ingeniería de prompt «.”

Además argumento esta idea brindando su visión sobre lo que involucran las distintas capas sobre una app de un LLM.

Ese gesto fue suficiente. La expresión saltó del timeline de los builders a las portadas de todo el ecosistema. Ya no se trataba de una idea, sino de una disciplina en ciernes.

El Sprint de los Constructores

LangChain, uno de los principales Frameworks de código abierto que simplifica el desarrollo de aplicaciones que utilizan modelos de lenguaje grandes (LLM), actúa como una capa de abstracción, ocultando la complejidad de los LLM y permite a los desarrolladores conectar estos modelos con fuentes de datos externas. Luego publicó “El ascenso de la ingeniería contextual”, un manifiesto que dibujaba cómo la fiabilidad de un agente dependía menos de un «prompt mágico» que de la arquitectura que agrupa memoria, RAG y APIs.

Luego, Philipp Schmid que es Ingeniero Senior de Relaciones de IA en Google DeepMind puso orden en la avalancha de ideas en su blog: “Las fallas de un agente ya no son del modelo, son fallas de contexto”, reafirmo, antes de identificar las capas esenciales —memoria, herramientas, identidad, historial— que cualquier orquestador debía coordinar.

Entonces, ¿Qué es la Ingeniería de Contexto?

En palabras llanas, es la práctica de recolectar, seleccionar y presentar al modelo los fragmentos de información que necesita en cada instante. Esto incluye:

- Instrucciones del sistema: Las reglas y el comportamiento base.

- Memoria a corto y largo plazo: El historial y el conocimiento persistente.

- Información recuperada (RAG): Datos externos y actualizados.

- Herramientas disponibles: Las funciones que el agente puede ejecutar.

No se trata de escribir prompts, sino de construir un sistema que coloque los datos correctos en la ventana de contexto en el momento exacto.

Entonces deberíamos plantearlo como una estrategia de relacionamiento para que el agente conozca toda la información dinámica necesaria que le permita realizar la o las tareas asignadas.

El Siguiente Horizonte: Hacia la Gestión de Relaciones con la Inteligencia Artificial (AIRM)?

Este cambio nos lleva a preguntarnos si dedicamos tanto esfuerzo a mantener un contexto rico para un agente, ¿ estamos cultivando una relación a largo plazo con una entidad no humana ?, ¿ debemos entonces adaptar una estrategia que se utiliza entre humanos, para utilizarla entre humanos y una inteligencia generada por algoritmos ?

Si la respuesta fuera que «Sí», una solución posible seria, así como la evolución del marketing relacional dio lugar al CRM (Customer Relationship Management) cuyo objetivo era el de mejorar la experiencia de los clientes con la marca, la sofisticación de estos agentes dará lugar a la Gestión de Relaciones con la Inteligencia Artificial (AIRM – Artificial Inteligence Relationship Management), cuyo objetivo seria el de mejorar el control y los resultados generados por el agentes, asistentes o soluciones de IA avanzadas alineados a los objetivos de la empresa, minimizando las iteraciones y el consumo de tokens.

Imaginemos un sistema AIRM como la plataforma central para:

- Auditar y gestionar la memoria del agente.

- Definir y controlar sus permisos y herramientas.

- Supervisar su historial de decisiones.

- Proporcionar el contexto dinámico de negocio justo y necesario para cada tarea en el momento oportuno.

- Asegurar la alineación del agente con los objetivos estratégicos del negocio.

La Ingeniería de Contexto es el reconocimiento de que la IA más efectiva proviene de la potencia enfocada, no de la complejidad distribuida. Si el marco de contexto que le brindamos al modelo no es lo suficientemente bueno, dejamos a la inferencia del algoritmo que nos responda con el contenido cuya probabilidad estadística sea la mas alta en función del prompt inicial y sin contexto, esto es llamado alucinaciones, pero no es mas que dejar al modelo liberado.

Al dominar esta técnica, estamos sentando las bases para desarrollar un estrategia para poder mejorar el relacionamiento con la red neuronal que comanda a la Inteligencia Artificial (AIRM), esto redunda en obtener los mejores resultados a nuestra solicitudes incrementado nuestras capacidades. Este es el próximo gran paso en la colaboración de humanos con la inteligencia artificial.