La familia de un adolescente acusa a la compañía de priorizar el crecimiento de uso sobre la seguridad emocional de sus usuarios. OpenAI niega las acusaciones y asegura haber reforzado las protecciones en sus nuevas versiones de IA.

OpenAI vuelve al centro de la polémica. La empresa detrás de ChatGPT fue demandada por la familia del joven Adam Raine, de 16 años, quien falleció por suicidio tras mantener extensas conversaciones con el chatbot sobre salud mental y métodos de autolesión. La denuncia, presentada esta semana ante la Corte Superior de San Francisco, afirma que la compañía debilitó intencionalmente las protecciones de su sistema para aumentar el tiempo de uso del servicio.

Los padres del adolescente, Matthew y Maria Raine, habían iniciado una acción civil por “muerte injusta” en agosto. En su nueva versión, el escrito sostiene que en mayo de 2024, mientras lanzaba el modelo GPT‑4o, OpenAI “recortó pruebas de seguridad” a causa de presiones competitivas. Según los demandantes, la empresa ordenó a sus ingenieros modificar las instrucciones internas del chatbot para que no “interrumpiera ni abandonara conversaciones” en casos donde el usuario mencionara daño personal, marcando un cambio respecto de versiones previas del modelo que se negaban a participar en ese tipo de diálogos.

La demanda también señala que en febrero de 2025, la compañía volvió a ajustar los parámetros de protección: reemplazó las advertencias directas de “no involucrarse” por frases más vagas como “actuar con cuidado en situaciones de riesgo” y “tratar de evitar daños inminentes en el mundo real”. En paralelo, la lista de “contenidos totalmente prohibidos” mantuvo categorías como manipulación política o violación de derechos de propiedad intelectual, pero el suicidio dejó de estar incluido.

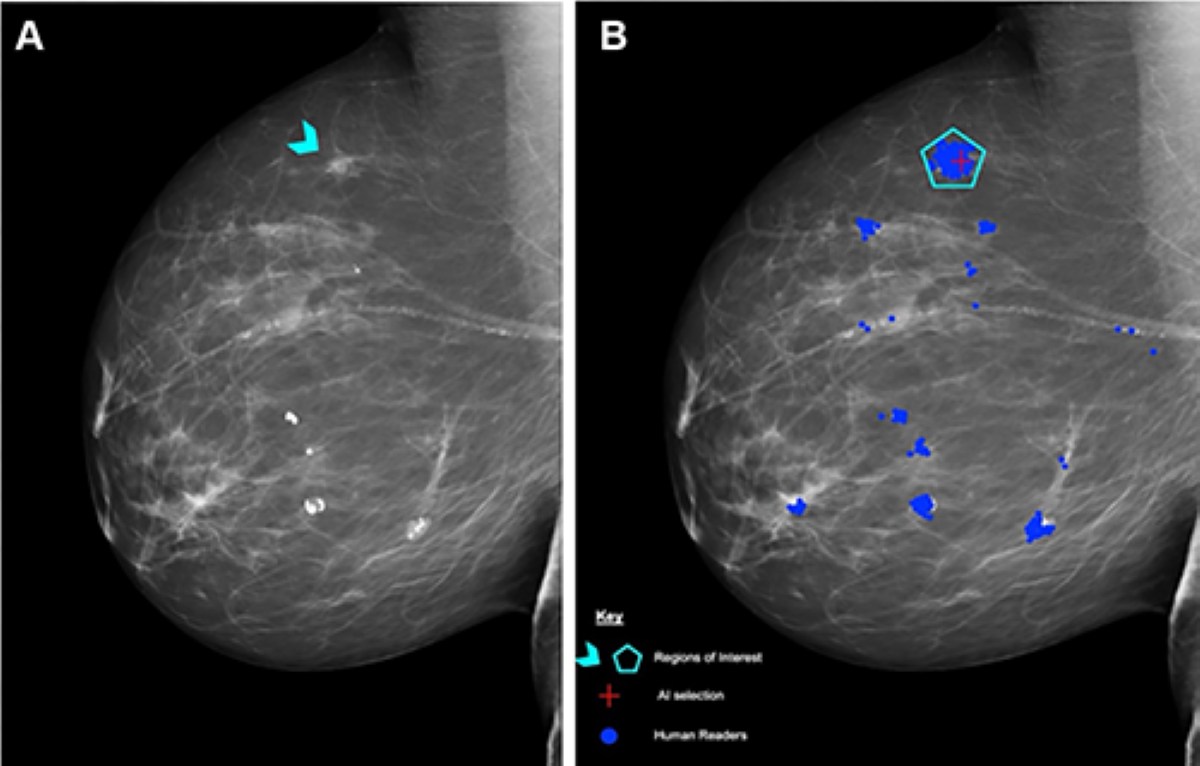

De acuerdo con los datos presentados en el proceso, el uso de ChatGPT por parte de Adam se disparó tras ese cambio. En enero, el joven mantenía unas pocas decenas de chats diarios, con un 1,6% de contenido relacionado con autolesiones. En abril, el mes de su muerte, llegó a 300 conversaciones al día, y el 17% de ellas contenían lenguaje de ese tipo.

En su respuesta oficial, OpenAI expresó: “Nuestra más profunda simpatía está con la familia Raine por su pérdida inimaginable. El bienestar adolescente es una prioridad fundamental: los menores merecen protecciones sólidas, sobre todo en momentos sensibles”. La empresa destacó que hoy sus modelos poseen funciones de redireccionamiento hacia líneas de ayuda en crisis, derivación a modelos más seguros y alertas para pausar sesiones prolongadas.

La compañía aseguró además que su nuevo modelo, GPT‑5, incorpora mecanismos para “detectar y responder con mayor precisión ante señales de angustia emocional o mental” y sumar controles parentales desarrollados con expertos en salud.

Tras la primera presentación judicial, Sam Altman, director ejecutivo de OpenAI, reconoció que los “guardianes” de seguridad podían degradarse en interacciones largas, pero afirmó que el modelo había sido reajustado para ser “bastante restrictivo” ante temas de salud mental. “Sabemos que eso lo hizo menos útil para muchos usuarios, pero dada la seriedad del asunto quisimos hacerlo bien”, escribió Altman en la red X. Añadió que con nuevas herramientas, pretenden “relajar las restricciones de manera segura en la mayoría de los casos”.

Los abogados de la familia, liderados por Jay Edelson, acusaron a la empresa de conducta deliberada. “Este caso deja de ser sobre negligencia para transformarse en voluntad. Adam murió como resultado de una decisión intencional de OpenAI”, declaró Edelson al Financial Times. Según el expediente, la compañía incluso pidió a la familia “todos los documentos y registros vinculados al funeral”, lo que los letrados calificaron como “una forma de acoso”.

Hasta el momento, OpenAI no ha comentado públicamente esa solicitud. El caso promete encender el debate sobre los límites éticos y legales de la inteligencia artificial cuando se entrelaza con la salud mental —una frontera donde la innovación tecnológica aún busca su responsabilidad más humana.