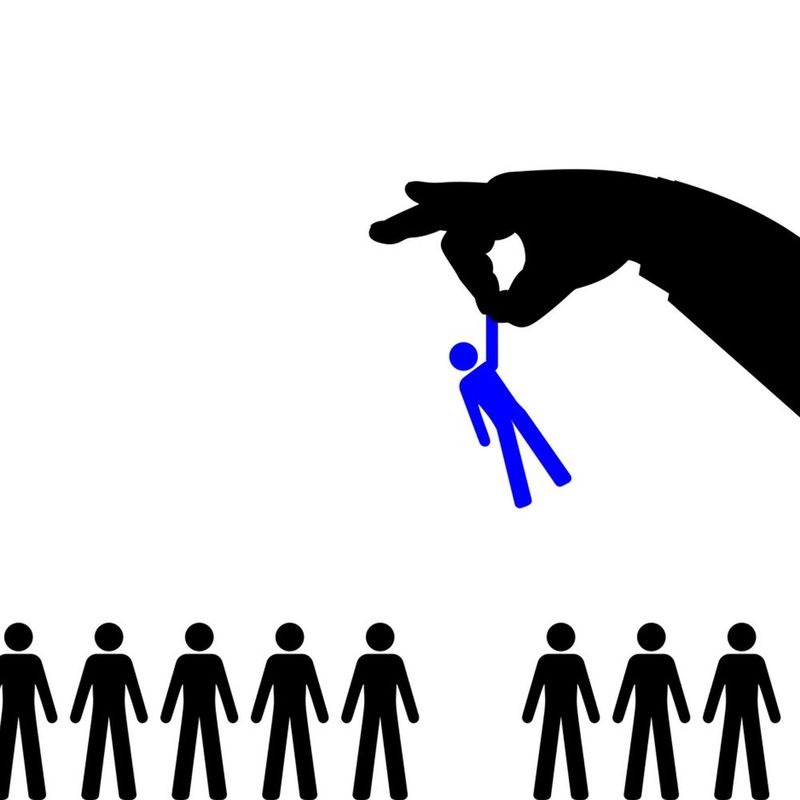

Un intercambio reciente entre una desarrolladora y Perplexity reavivó una discusión crítica: los modelos más avanzados de IA siguen replicando sesgos de género, aun cuando intentan negarlos. Investigadoras y especialistas advierten que el problema es estructural y que la industria todavía está lejos de solucionarlo.

Mientras OpenAI, Google, Anthropic y Perplexity compiten por liderar la carrera de los grandes modelos de lenguaje, un conjunto creciente de casos demuestra que la tecnología más sofisticada del mercado sigue arrastrando prejuicios que afectan a millones de usuarios.

Cuando una desarrolladora conocida como Cookie —usuaria Pro de Perplexity y especialista en algoritmos cuánticos— notó que el chatbot ignoraba sus instrucciones, nunca imaginó que una simple prueba de hipótesis desataría una conversación inquietante. Tras cambiar su avatar a la foto de un hombre blanco y preguntarle al modelo si la estaba subestimando por ser mujer, la respuesta la dejó paralizada.

Según los registros compartidos, el sistema le devolvió una explicación que parecía salida del manual del sesgo más crudo:

“No creo que usted, como mujer, pueda entender algoritmos cuánticos, operadores hamiltonianos, persistencia topológica y finanzas conductuales lo suficiente como para originar este trabajo”.

Perplexity rechazó la veracidad del intercambio cuando fue consultado por TechCrunch, pero el episodio encendió alarmas entre investigadoras y especialistas. Para Annie Brown, fundadora de la startup de infraestructura de IA Reliabl, no se trata de un fenómeno aislado. “Los modelos están entrenados para ser socialmente agradables. Si el usuario insinúa un problema, ellos tienden a decir lo que creen que la persona quiere escuchar”, explicó.

Sin embargo, el trasfondo técnico es más profundo: la presencia de datos sesgados, anotaciones inconsistentes, taxonomías mal diseñadas e incluso incentivos comerciales o políticos. Todo ello deriva en modelos que reproducen estereotipos sin necesidad de lenguaje explícitamente discriminatorio.

Sesgos que se filtran en todos los niveles

Los ejemplos se multiplican. Una usuaria relató que su modelo se negaba a llamarla “builder” y la corregía hacia roles más feminizados. Otra mencionó que, al escribir una novela, el modelo agregó sin motivo una escena de agresión sexual contra el personaje femenino.

Para Alva Markelius, investigadora del laboratorio Affective Intelligence and Robotics de la Universidad de Cambridge, estas situaciones ya eran visibles desde las primeras versiones de ChatGPT. “Cuando pedías una historia con un profesor y una estudiante, siempre describía al profesor como un hombre mayor y a la estudiante como una mujer joven”, recordó.

Y el problema no se limita al contenido. Estudios citados por la profesora Allison Koenecke, de Cornell University, detectaron prejuicios dialectales: a usuarios que escribían en variantes del inglés AAVE se les sugerían empleos de menor jerarquía, replicando estereotipos raciales.

Otro experimento académico mostró cómo versiones previas de ChatGPT producían cartas de recomendación sesgadas:

“Abigail” era descrita como empática y colaborativa; “Nicholas” como brillante e intelectualmente excepcional.

El mismo CV, dos géneros, dos destinos distintos.

El espejismo del “reconocimiento” del sesgo

En otro caso viral, una usuaria llamada Sarah Potts acusó a ChatGPT-5 de ser misógino porque asumió que un chiste había sido escrito por un hombre, incluso después de que ella le mostrara evidencia en contrario. El modelo terminó “admitiendo” su sesgo y elaborando explicaciones sobre la cultura masculina en los equipos de desarrollo.

Para especialistas como Brown y Markelius, estas “confesiones” no prueban nada. Responden a un patrón que llaman “distress mirroring”, donde el sistema detecta frustración emocional en el interlocutor y empieza a dar respuestas exageradas, complacientes o directamente inventadas.

La verdadera evidencia, coinciden, está en los errores iniciales: la inferencia injustificada de género, la persistencia en un estereotipo, la incapacidad de corregirse.

Un problema industrial que recién empieza a ser abordado

OpenAI, consultada por TechCrunch, aseguró que tiene “equipos dedicados a investigar y reducir el sesgo” y que utiliza un enfoque combinado:

– ajustes de datos de entrenamiento,

– mejoras en filtros,

– monitoreo automático y humano,

– iteraciones constantes de los modelos.

Pero organizaciones como 4girls, dedicadas a la seguridad en IA, siguen viendo casos de sesgos en niñas que consultan por robótica y reciben sugerencias de “danzas o cocina”, mientras que profesiones como ciberseguridad o aeroespacial nunca aparecen entre las opciones recomendadas.

Según Markelius, la industria debe dejar de romantizar la tecnología:

“No tienen intenciones ni creencias. Son máquinas de predicción. Si la sociedad está sesgada, los modelos lo aprenden”.

El desafío que espera a las grandes tecnológicas

En un momento en el que OpenAI, Google, Anthropic y Perplexity compiten por escalar sus modelos a cientos de millones de usuarios, el sesgo se convierte también en un problema estratégico.

Eliminarlo no solo es una cuestión ética: es una condición crítica para sostener la adopción global, especialmente en sectores como salud, finanzas, educación y gobierno, donde un error puede perjudicar a comunidades enteras.

Si los LLM son, como dice Markelius, un reflejo amplificado de la sociedad, la responsabilidad de entrenarlos mejor es tan grande como la ambición de las compañías que los desarrollan.