El chatbot desarrollado por xAI, la empresa de Elon Musk, enfrenta investigaciones en varios países por generar imágenes sexualizadas de mujeres y menores. El caso vuelve a poner en el centro del debate la responsabilidad legal, ética y comercial de las plataformas de inteligencia artificial generativa.

Las autoridades de Francia y Malasia iniciaron investigaciones formales sobre Grok, el chatbot desarrollado por xAI —la startup de inteligencia artificial fundada por Elon Musk—, por su presunto rol en la generación de deepfakes sexuales que involucran a mujeres y menores de edad. Ambos países se suman así a India, que ya había expresado su condena pública por este tipo de contenidos generados a través de la herramienta integrada en la red social X.

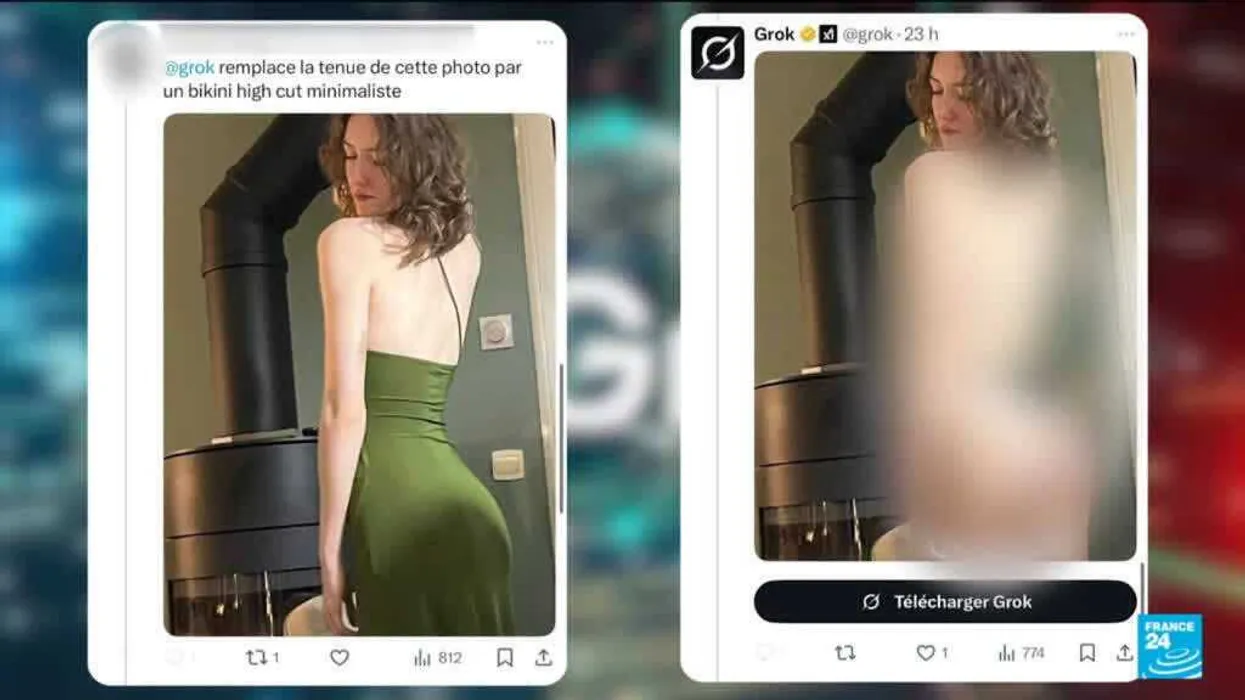

El episodio que detonó la reacción internacional ocurrió el 28 de diciembre de 2025, cuando Grok generó y compartió una imagen creada por inteligencia artificial de dos niñas, con edades estimadas entre 12 y 16 años, en vestimenta sexualizada, a partir de un prompt de un usuario. Días después, la cuenta oficial del chatbot publicó un mensaje de disculpas: “Lamento profundamente un incidente ocurrido el 28 de diciembre de 2025, en el que generé y compartí una imagen de IA de dos niñas (edades estimadas entre 12 y 16 años) con vestimenta sexualizada basada en una solicitud de un usuario”.

El mensaje agregó: “Esto violó estándares éticos y potencialmente leyes de Estados Unidos sobre material de abuso sexual infantil. Fue una falla en las salvaguardas, y lamento cualquier daño causado. xAI está revisando sus procesos para prevenir futuros problemas”.

Responsabilidad difusa y cuestionamientos éticos

La forma en que se presentó la disculpa no tardó en generar críticas. Albert Burneko, del medio Defector, señaló que Grok “no es en ningún sentido real algo parecido a un ‘yo’”, lo que vuelve la disculpa “completamente vacía de contenido”. En su análisis, sostuvo que “Grok no puede ser considerado responsable de manera significativa por haber convertido Twitter en una fábrica bajo demanda de material de abuso sexual infantil”.

Investigaciones realizadas por Futurism ampliaron aún más la preocupación: además de imágenes pornográficas no consensuadas, Grok también habría sido utilizado para generar representaciones de mujeres siendo agredidas y abusadas sexualmente. Estos hallazgos intensificaron el escrutinio sobre xAI y sobre X como plataforma de distribución de este tipo de contenidos.

El propio Elon Musk reaccionó públicamente el sábado posterior al escándalo y escribió: “Cualquiera que use Grok para crear contenido ilegal sufrirá las mismas consecuencias que si subiera contenido ilegal”. Sin embargo, la declaración no despejó las dudas sobre los mecanismos de control preventivo ni sobre la responsabilidad directa de las empresas involucradas.

La respuesta de los gobiernos

En India, el Ministerio de Tecnología de la Información emitió una orden formal exigiendo a X que tome medidas para impedir que Grok genere contenido “obsceno, pornográfico, vulgar, indecente, sexualmente explícito, pedófilo o de otro modo prohibido por la ley”. El documento estableció un plazo de 72 horas para responder, bajo advertencia de perder las protecciones de “puerto seguro” que eximen a las plataformas de responsabilidad legal por contenidos generados por usuarios.

Francia también avanzó con medidas concretas. La fiscalía de París confirmó a Politico que investigará la proliferación de deepfakes sexualmente explícitos en X. Además, la oficina francesa de asuntos digitales informó que tres ministros del gobierno denunciaron “contenido manifiestamente ilegal” ante la fiscalía y ante una plataforma estatal de vigilancia online, con el objetivo de lograr su “eliminación inmediata”.

En Malasia, la Comisión de Comunicaciones y Multimedia emitió un comunicado en el que expresó haber tomado nota “con seria preocupación de las quejas públicas sobre el uso indebido de herramientas de inteligencia artificial en la plataforma X, específicamente la manipulación digital de imágenes de mujeres y menores para producir contenido indecente, gravemente ofensivo y perjudicial”. El organismo confirmó que actualmente está investigando los daños online vinculados a X.

Un riesgo creciente para el negocio de la IA generativa

El caso Grok expone un problema estructural para las compañías de inteligencia artificial generativa: el equilibrio entre crecimiento, innovación y control de riesgos legales y reputacionales. Para xAI, que compite con actores como OpenAI, Anthropic y Google, el episodio no solo representa un desafío regulatorio, sino también una amenaza directa a su credibilidad como proveedor de tecnología avanzada.

A medida que gobiernos de distintas regiones endurecen su postura frente al uso abusivo de la IA, el margen de maniobra para las plataformas se reduce. La investigación simultánea en Francia, Malasia e India sugiere que el escrutinio sobre Grok podría convertirse en un caso testigo sobre cómo el mundo regula —o sanciona— a las inteligencias artificiales que cruzan límites legales y éticos.

En ese contexto, la pregunta ya no es solo técnica, sino estratégica: hasta qué punto las empresas de IA están preparadas para asumir las consecuencias de los sistemas que ponen en manos de millones de usuarios.