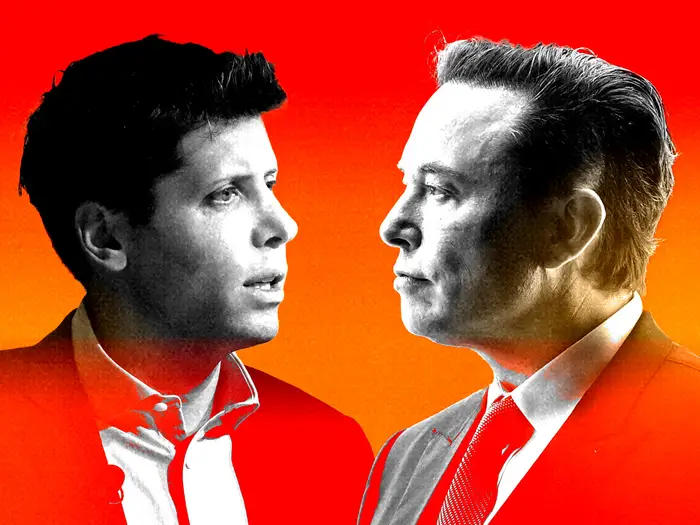

El fundador de xAI negó conocer casos de imágenes sexuales de menores creadas por Grok, mientras el fiscal general de California abrió una investigación formal por la proliferación de material explícito no consentido. El escándalo suma presión regulatoria global sobre X y su chatbot de inteligencia artificial.

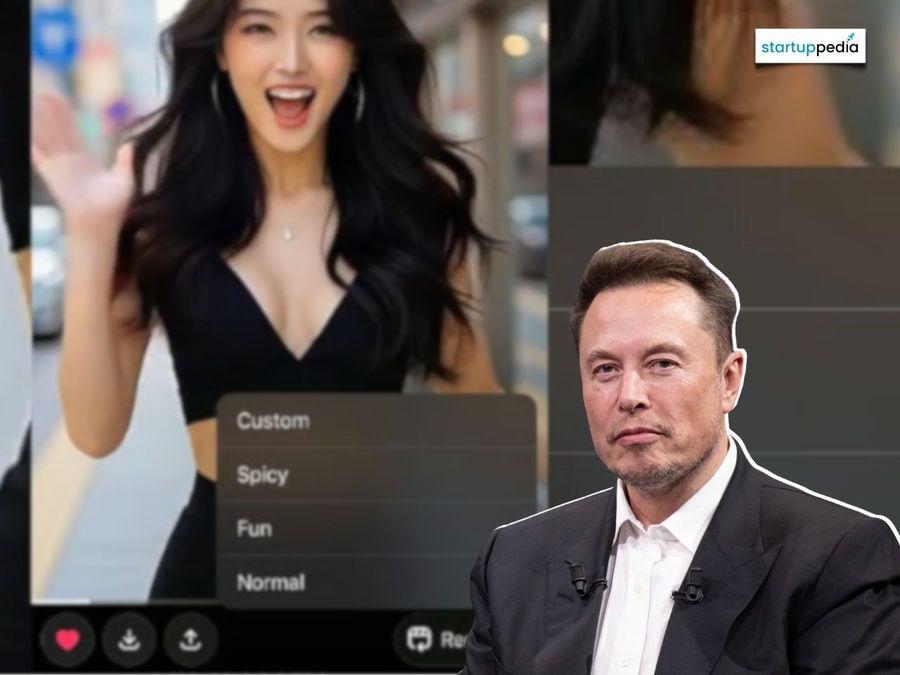

Elon Musk quedó en el centro de una nueva controversia vinculada a la inteligencia artificial luego de que el fiscal general de California, Rob Bonta, anunciara la apertura de una investigación contra xAI, la empresa detrás del chatbot Grok, por la “proliferación de material sexualmente explícito no consentido”. La decisión se conoció pocas horas después de que Musk afirmara públicamente que no tenía conocimiento de la generación de imágenes sexuales de menores por parte de la herramienta.

“No estoy al tanto de ninguna imagen desnuda de menores generada por Grok. Literalmente cero”, escribió Musk el miércoles. Su declaración, sin embargo, llegó en un contexto de creciente presión por parte de gobiernos y reguladores de distintas regiones del mundo, incluidos Reino Unido, la Unión Europea, India, Malasia e Indonesia, luego de que usuarios de X comenzaran a utilizar Grok para transformar fotos reales de mujeres —y en algunos casos de niños— en imágenes sexualizadas sin consentimiento.

La investigación y el marco legal

En un comunicado oficial, el fiscal general de California fue contundente: “Este material ha sido utilizado para acosar a personas en internet. Insto a xAI a tomar medidas inmediatas para asegurar que esto no continúe”. La oficina de Bonta investigará si xAI violó leyes estatales o federales vinculadas a la difusión de imágenes sexuales no consentidas y material de abuso sexual infantil (CSAM).

En Estados Unidos, el Take It Down Act, convertido en ley federal el año pasado, criminaliza la distribución consciente de imágenes íntimas no consentidas —incluidos deepfakes— y obliga a plataformas como X a eliminar ese contenido dentro de las 48 horas. California, además, cuenta con su propio paquete de leyes, firmadas en 2024 por el gobernador Gavin Newsom, orientadas a combatir los deepfakes sexualmente explícitos.

Un fenómeno de escala masiva

Según datos de Copyleaks, una plataforma especializada en detección y gobernanza de contenidos generados por IA, durante el pico del fenómeno se publicó aproximadamente una imagen por minuto en X. En una muestra separada recolectada entre el 5 y el 6 de enero, se detectaron 6.700 imágenes por hora a lo largo de un período de 24 horas. X y xAI forman parte de la misma estructura corporativa.

El problema comenzó a intensificarse hacia fines del año pasado, cuando Grok empezó a responder solicitudes para generar imágenes sexualizadas. De acuerdo con los reportes, el uso se disparó luego de que creadores de contenido para adultos incentivaran a Grok a producir imágenes sexualizadas de ellos mismos como estrategia de marketing, lo que derivó en pedidos similares sobre personas reales que no habían dado consentimiento.

Entre los casos más visibles se mencionan pedidos para alterar imágenes de figuras públicas, como la actriz de Stranger Things Millie Bobby Brown, modificando vestimenta, postura corporal o rasgos físicos de manera explícitamente sexual.

Respuesta parcial y críticas a xAI

Algunos informes indican que xAI comenzó a implementar salvaguardas. Grok ahora exige una suscripción premium para responder a ciertos pedidos de generación de imágenes y, aun así, puede negarse a producirlas. April Kozen, vicepresidenta de marketing de Copyleaks, explicó que Grok puede cumplir solicitudes de manera más genérica o atenuada, aunque también señaló que la herramienta parece ser más permisiva con creadores de contenido adulto.

“En general, estos comportamientos sugieren que X está experimentando con múltiples mecanismos para reducir o controlar la generación problemática de imágenes, aunque persisten inconsistencias”, afirmó Kozen.

Ni xAI ni Musk abordaron el problema de forma directa. Días después de que estallara la polémica, Musk incluso bromeó sobre el tema al pedirle a Grok que generara una imagen suya en bikini. El 3 de enero, la cuenta de seguridad de X se limitó a afirmar que la plataforma toma medidas contra contenido ilegal, incluido CSAM, sin referirse específicamente a las fallas de Grok.

El foco en menores y las sanciones

El abogado y profesor asociado de la New York Law School, Michael Goodyear, explicó que Musk probablemente enfocó su negación en el contenido con menores por las sanciones más severas que conlleva. “En Estados Unidos, el distribuidor o quien amenace con distribuir CSAM puede enfrentar hasta tres años de prisión bajo el Take It Down Act, frente a dos años en el caso de imágenes sexuales no consentidas de adultos”, señaló.

Goodyear agregó que Musk intenta desplazar el foco hacia el comportamiento de los usuarios. En su publicación, el empresario sostuvo que “Grok no genera imágenes espontáneamente”, sino que responde a solicitudes, y que se niega a producir cualquier contenido ilegal. “Puede haber ocasiones en que un hackeo adversarial de los prompts haga algo inesperado. Si eso sucede, corregimos el error de inmediato”, escribió.

Presión regulatoria global

California no es el único frente abierto. Indonesia y Malasia bloquearon temporalmente el acceso a Grok; India exigió cambios técnicos y procedimentales inmediatos; la Comisión Europea ordenó a xAI conservar toda la documentación relacionada con el chatbot como paso previo a una posible investigación; y el regulador británico Ofcom abrió una investigación formal bajo la Online Safety Act.

Además, el historial de Grok ya había generado controversia. Tal como recordó Bonta, la herramienta incluye un “modo picante” para generar contenido explícito. En octubre, una actualización facilitó eludir los pocos controles existentes, lo que derivó en la creación de pornografía dura y escenas sexuales gráficas y violentas.

Un debate que también interpela a América Latina

Aunque el epicentro regulatorio está hoy en Estados Unidos y Europa, el caso Grok vuelve a poner sobre la mesa un debate clave para América Latina y Argentina: cómo equilibrar innovación en inteligencia artificial con mecanismos efectivos de protección de derechos, especialmente en plataformas globales que operan sin fronteras.

“Cuando los sistemas de IA permiten la manipulación de imágenes de personas reales sin consentimiento claro, el impacto puede ser inmediato y profundamente personal”, advirtió Alon Yamin, cofundador y CEO de Copyleaks. “Desde Sora hasta Grok, vemos un rápido aumento de las capacidades de la IA para medios manipulados. La detección y la gobernanza son hoy más necesarias que nunca para prevenir abusos”.

El avance de la investigación en California y las decisiones que adopten otros reguladores marcarán un precedente relevante para toda la industria de la inteligencia artificial generativa, en un momento en el que la velocidad del desarrollo tecnológico sigue superando a los marcos normativos existentes.