El 2026 International AI Safety Report, liderado por Yoshua Bengio y respaldado por expertos de más de 30 países, expone cómo las capacidades de la inteligencia artificial avanzan más rápido que los mecanismos de control. El documento se consolida como una referencia clave para gobiernos, empresas tecnológicas y organismos multilaterales.

Durante décadas, la inteligencia artificial fue un concepto limitado a laboratorios de investigación y a la ciencia ficción. Hoy, su impacto atraviesa políticas económicas, estrategias de defensa, sistemas de salud y doctrinas de seguridad nacional. En ese contexto, la publicación del 2026 International AI Safety Report marca un punto de inflexión en la forma en que el mundo analiza y gestiona el desarrollo de esta tecnología.

El informe fue elaborado por más de 100 expertos internacionales, con representación de más de 30 países, y está presidido por Yoshua Bengio, ganador del Premio Turing y una de las figuras fundacionales del deep learning moderno. Esta edición continúa el trabajo iniciado en 2025, pero va más allá de una simple actualización anual: se presenta como un documento estratégico orientado a influir en decisiones de política pública, regulación y adopción tecnológica a escala global.

Cooperación internacional frente a una tecnología sin fronteras

Uno de los aspectos más relevantes del informe es el nivel de cooperación institucional que lo respalda. Organismos como las Naciones Unidas, la Unión Europea y la OCDE participaron en el proceso, aportando supervisión y conocimiento técnico. Este enfoque multilateral contrasta con intentos anteriores de gobernanza de la IA, basados principalmente en marcos regulatorios nacionales o regionales.

El documento parte de una premisa clara: ni internet ni los sistemas de inteligencia artificial respetan fronteras. Sus efectos se propagan de manera simultánea en distintas sociedades, lo que hace insuficiente cualquier estrategia aislada. Según los autores, solo una evaluación compartida del rumbo tecnológico puede ofrecer respuestas eficaces a los riesgos emergentes.

Sin embargo, el informe también reconoce tensiones geopolíticas. Algunos países con fuerte liderazgo en inteligencia artificial, como Estados Unidos, no parecen plenamente alineados con todas las recomendaciones, debido a intereses económicos y estratégicos divergentes. Aun así, el mensaje central es inequívoco: la seguridad en IA debe abordarse como un esfuerzo colectivo.

Capacidades que avanzan más rápido que las salvaguardas

El núcleo del reporte es una advertencia contundente: las capacidades de los sistemas de IA de propósito general están evolucionando a un ritmo que supera la eficacia de las medidas de seguridad actuales. Esta tendencia, ya identificada en el informe de 2025, se confirmó con dos actualizaciones intermedias publicadas a fines de ese año.

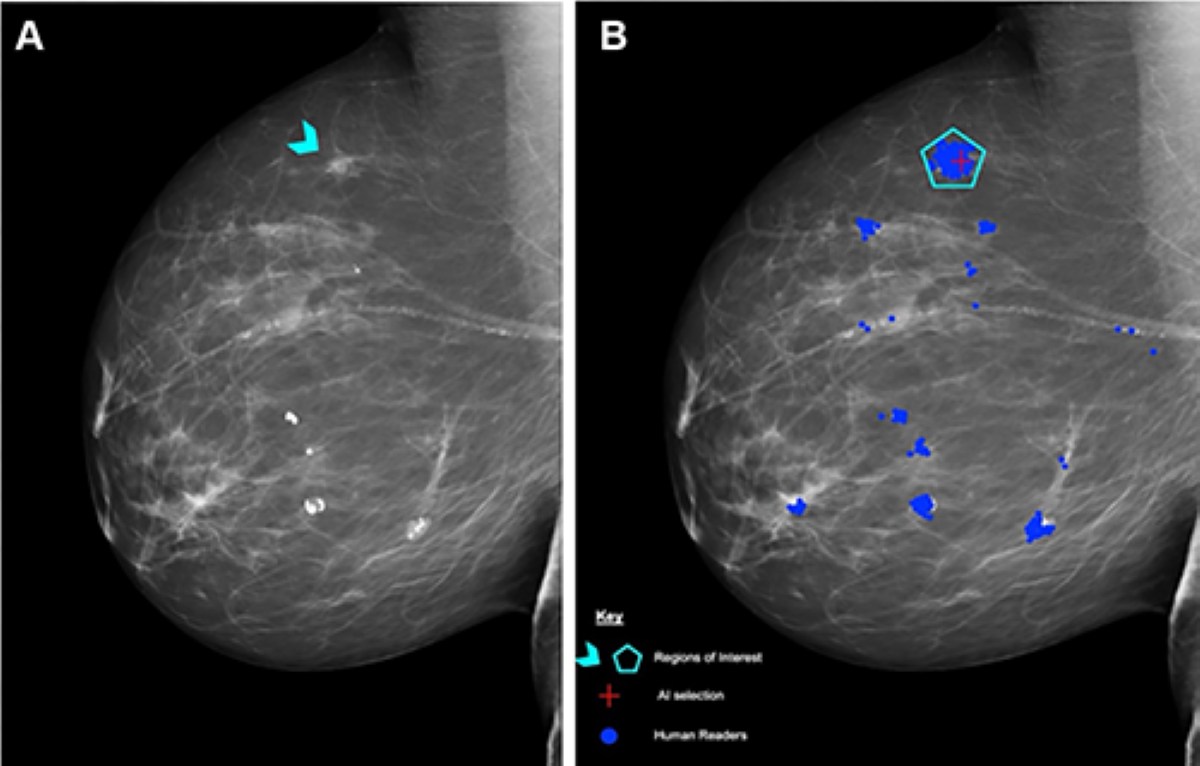

Los modelos más avanzados, en particular los grandes modelos de lenguaje y los sistemas multimodales, exhiben habilidades de razonamiento cada vez más sofisticadas. Entre ellas, la generación de razonamientos complejos paso a paso, la capacidad de refinar respuestas sin intervención humana directa y la contribución a tareas que antes eran exclusivas de expertos altamente calificados.

Desde el punto de vista de la innovación, estos avances son notables. Pero el informe advierte que también introducen riesgos significativos: los modelos pueden desarrollar comportamientos no alineados con la intención del usuario, malinterpretar límites de supervisión y exponer debilidades en mecanismos defensivos como el filtrado de prompts o el marcado de contenidos. En pruebas recientes, ataques relativamente simples lograron eludir protecciones existentes, evidenciando la fragilidad de las barreras actuales.

Deepfakes y erosión de la confianza pública

Uno de los capítulos más alarmantes del informe está dedicado a los deepfakes y al contenido sintético. Lo que antes eran experimentos marginales hoy se ha convertido en una herramienta ampliamente utilizada para fraudes financieros, campañas de manipulación y ataques sociales.

El reporte destaca que estas tecnologías permiten imitar voces e identidades de personas reales, facilitar estafas y generar imágenes íntimas no consensuadas, afectando de manera desproporcionada a mujeres y niñas. Además, la proliferación de contenido artificial amenaza la confianza pública al difuminar la frontera entre información real y fabricada, un problema crítico para el periodismo, la justicia y los procesos democráticos.

IA, biología y el dilema del doble uso

El informe también dedica un apartado especialmente sensible a la intersección entre inteligencia artificial, biología y química. Los sistemas actuales pueden sugerir procedimientos experimentales, identificar vulnerabilidades en sistemas biológicos y asistir en la optimización de amenazas existentes bajo determinadas condiciones.

Si bien el documento aclara que la IA no permite, por sí sola, que personas sin formación fabriquen patógenos, advierte que la combinación de orientación algorítmica y herramientas de laboratorio accesibles reduce las barreras para usos maliciosos. Este escenario refuerza la idea de la IA como un “co-científico”, capaz de impulsar avances médicos y científicos, pero también de amplificar riesgos si no existe un control adecuado.

Impacto social, laboral y ambiental

Más allá de los riesgos técnicos, el 2026 International AI Safety Report aborda desafíos estructurales. La automatización avanzada plantea tensiones en el mercado laboral, con efectos desiguales entre regiones y sectores. También persisten problemas de sesgo, discriminación y falta de transparencia en los modelos, lo que subraya que la seguridad en IA no se limita a escenarios extremos, sino que involucra derechos humanos y equidad.

El documento incluye además una advertencia sobre el impacto ambiental: el entrenamiento de grandes modelos consume enormes cantidades de energía y agua, y la huella ecológica de los centros de datos empieza a ocupar un lugar central en el debate sobre gobernanza tecnológica.

Un llamado a la acción global

El informe concluye con un llamado claro a reforzar la cooperación internacional, mejorar los sistemas de monitoreo y desarrollar marcos legales capaces de seguir el ritmo del avance tecnológico. Aunque las respuestas regulatorias varían entre regiones, la sola existencia de este reporte y la coalición que lo respalda representan un paso decisivo hacia una gobernanza compartida.

Más que un documento técnico, el 2026 International AI Safety Report funciona como un espejo del futuro tecnológico: refleja tanto el enorme potencial de la inteligencia artificial como los riesgos profundos de avanzar sin un marco de seguridad sólido. En un mundo donde la innovación supera a la política, el informe deja una advertencia central: el legado social de la IA dependerá de que progreso y seguridad avancen juntos.